jueves, 6 de junio de 2019

miércoles, 5 de junio de 2019

martes, 4 de junio de 2019

lunes, 3 de junio de 2019

jueves, 30 de mayo de 2019

miércoles, 29 de mayo de 2019

lunes, 27 de mayo de 2019

lunes, 13 de mayo de 2019

jueves, 9 de mayo de 2019

martes, 7 de mayo de 2019

4 unidad elaboración de programas

La programación es un proceso que se utiliza para idear y ordenar las acciones que se realizarán en el marco de un proyecto; al anuncio de las partes que componen un acto o espectáculo; a la preparación de máquinas para que cumplan con una cierta tarea en un momento determinado; a la elaboración de programas para la resolución de problemas mediante ordenadores, y a la preparación de los datos necesarios para obtener una solución de un problema.[cita requerida]

En la actualidad, la noción de programación se encuentra muy asociada a la creación de aplicaciones informática y videojuegos. Es el proceso por el cual una persona desarrolla un programa valiéndose de una herramienta que le permita escribir el código (el cual puede estar en uno o varios lenguajes, como C++, Java y Python, entre otros) y de otra que sea capaz de “traducirlo” a lo que se conoce como lenguaje de máquina, que puede comprender el microprocesador.

Un lenguaje de programación es un lenguaje formal diseñado para realizar procesos que pueden ser llevados a cabo por máquinas como las computadoras. Pueden usarse para crear programas que controlen el comportamiento físico y lógico de una máquina, para expresar algoritmos con precisión, o como modo de comunicación humana. Está formado por un conjunto de símbolos y reglas sintácticas y semánticas que definen su estructura y el significado de sus elementos y expresiones. Al proceso por el cual se escribe, se prueba, se depura, se compila (de ser necesario) y se mantiene el código fuente de un programa informático se le llama programación. Un lenguaje de programación proporciona los elementos de lenguaje necesarios que son necesarios para traducir los pasos de un pseudocódigo en formato comprensible de la máquina. En otras palabras, el lenguaje de programación proporciona el puente para hacer la transición de pseudocódigo legible por humano instrucciones legible por máquina. Las dos clasificaciones principales de lenguajes de programación son: bajo nivel de lenguaje de programación y lenguaje de programación de alto nivel.

Luis Olarte Gervacio. (2018). Lenguaje de Programación. 2019, Mayo 7, Conogasi.org Sitio web: http://conogasi.org/articulos/lenguaje-de-programacion/

Luis Olarte Gervacio. (2018). Lenguaje de Programación. 2019, Mayo 7, Conogasi.org Sitio web: http://conogasi.org/articulos/lenguaje-de-programacion/

4 unidad repetir desde

El bucle repetir comprueba la condición de finalización al final del cuerpo del bucle, y si ésta es cierta continua con el resto del programa, a veces esto resulta más adecuado.

- Una situación típica en la que resulta cómoda el empleo de esta sentencia es la que se produce cuando al finalizar cada iteración se pregunta al operador si desea continuar con otra nueva. En estos casos, el programa siempre realiza la primera iteración y según la condición de salida la repite. Otro caso también típico son los filtros de entrada de datos, donde se comprueba si el valor de la entrada esta en un rango de valores.

- Admite un número del 3 al 7, si no pregunta de nuevo

REPEAT WriteString(“Escribe el numero”) ReadInt(numero); UNTIL (numero >= 3) AND (numero <= 7)

4 unidad repetir hasta

Una de las características importantes que se pueden aprovechar de las computadoras es precisamente su capacidad de repetir la ejecución de secuencias de instrucciones a una gran velocidad y con alto grado de confiabilidad. Para estos fines, precisamente se definen en los lenguajes de programación las estructuras de control iterativas. El objetivo de estas estructuras es permitir la expresión de la repetición de una secuencia de instrucciones, a estas estructuras se les denomina ciclo, lazo o bucle.

En la vida diaria existen situaciones que frecuentemente se resuelven realizando una determinada secuencia de pasos que puede repetirse muchas veces, ejemplo:

- El proceso que seguimos para comer, mientras no se termine la comida.

- El proceso de insertar monedas, hasta que se abone la cantidad necesaria.

- Las operaciones que realizamos para llamar por teléfono, mientras no se logre la comunicación.

Como se puede observar estos son algoritmos que se hacen cotidianamente, pero tienen la particularidad de que la ejecución de alguno de sus pasos puede repetirse muchas veces, mientras no se logre la meta trazada. A este tipo de algoritmo se le conoce como algoritmos iterativos o repetitivos. En C#, las instrucciones while, do/while, y for, permiten ejecutar iteraciones, bucles o ciclos. En cada caso se ejecuta un bloque de instrucciones mientras la condición que se evalúa tome valor verdadero. Se resalta que cualquiera de las 3 instrucciones cumple con el mismo objetivo que es el de ejecutar una secuencia de pasos, más de una vez.

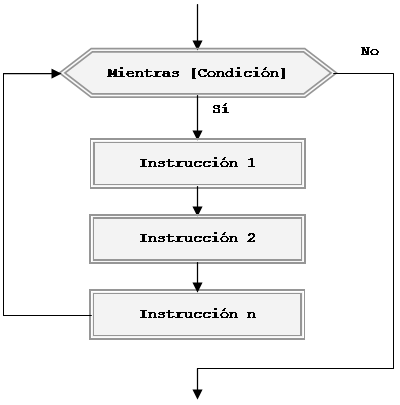

La semántica de la instrucción es la siguiente:

- <condición>. Está representada por una expresión booleana y mientras se cumpla se ejecutará el ciclo.

- [Bloque de Instrucciones] El bloque de instrucciones puede estar formado por una o varias instrucciones y es el conjunto de pasos que se van ejecutar en cada iteración del ciclo.

Para una mayor comprensión se muestra su representación en un diagrama de actividad.

Esta estructura de control permite repetir o iterar el [Bloque de Instrucciones] mientras la condición sea verdadera o dicho de otra manera, estas iteraciones terminarán cuando la condición sea falsa y entonces se podrá ejecutar la siguiente instrucción después del while.

4 unidad Repetir mientras

INSTRUCCIÓN HACER … REPETIR MIENTRAS

La instrucción Hacer ... Repetir Mientras se usa para repetir un proceso que necesariamente se ejecuta al menos una vez. Ahí radica su diferencia con Mientras ... Hacer, ya que ésta puede llegar a no ejecutarse si no se cumple la condición de entrada.

Escribiremos y representaremos esta instrucción de la siguiente manera:

Como es habitual, el sangrado se convierte en fundamental para una buena compresión de qué es el bloque subordinado y cuáles son sus límites. La entrada al bucle queda controlada mediante la evaluación de una condición (verdadera o falsa). En general, el bucle se repetirá varias veces hasta que se incumpla la condición de entrada, para continuar el flujo del programa por la siguiente instrucción después de Repetir. Sin embargo, podría darse el caso particular de que en la primera evaluación no se cumpla la condición, con lo cual el bloque de instrucciones del bucle no llegaría a ejecutarse siquiera una vez. Si tras la primera pasada la condición cambia y se convierte en falsa, el bloque se ejecuta una única vez. Gráficamente utilizaremos la siguiente representación:

La instrucción Mientras ... Hacer es anidable dentro de sí misma mediante la inserción de un bloque Mientras dentro de otro. Una vez más, el sangrado nos permitirá identificar las subordinaciones y habremos de verificar que toda apertura Mientras tiene su cierre Repetir.

lunes, 6 de mayo de 2019

jueves, 2 de mayo de 2019

lunes, 29 de abril de 2019

3 unidad operadores operandos y expreciones

Referente a la parte de la instrucción de lenguaje máquina de la computadora que designa la dirección de los datos con los que se debe operar.

*Expresion:

Una expresión es una secuencia de operadores y operandos que describe un cálculo. Normalmente una expresión se evalúa en tiempo de ejecución.

Una expresión es una secuencia de operadores y operandos que describe un cálculo. Normalmente una expresión se evalúa en tiempo de ejecución.*OPERADORES:

operadores: un operador es el símbolo que determina el tipo de operación o relación que habrá que establecerse entre los operandos de una expresión para alcanzar un resultado.

Los operadores se clasifican en tres grupos:

- Aritméticos

- Relacionales

- Lógicos

En este tema se presentan los siguientes elementos de la programación: las expresiones y los operadores. Se define el concepto de expresión y se continúa con el estudio de los distintos tipos de operadores: aritmético, de relación, boléanos y de bit. En el apartado final se analizan las reglas de prioridad de los operadores que se siguen en la evaluación de expresiones de todo tipo. Objetivos específicos. Al finalizar el tema, el alumno deberá ser capaz de: a) Describir los operadores (asignación, aritméticos, de relación, lógicos y de bit) y los tipos de dato sobre los que actúan (Conocimiento) b) Evaluar expresiones que empleen datos primitivos, operadores y paréntesis (Comprensión) c) Construir expresiones que empleen combinaciones de datos simples, operadores y paréntesis (Aplicación)

3 unidad proposicion de asignacion

3 unidad almacenamiento direccionamiento y representación en memoria

ALMACENAMIENTO,DIRECCIONAMIENTO Y REPRESENTACION DE MEMORIAS

Almacenamiento

Supongamos que la memoria utilizada tiene un tamaño de 4 Gigabytes y por tanto sus direcciones se representan con 32 bits. Las direcciones de memoria son números naturales en el rango [0, 232 – 1]. Pero este número natural es susceptible de ser almacenado él mismo en memoria. Es decir, se puede almacenar la representación binaria de una dirección de memoria en la propia memoria. Al tener un tamaño de 32 bits o 4 bytes, se utilizan para ello cuatro posiciones de memoria consecutivas.

Una dirección de memoria, por tanto, se puede considerar de dos formas posibles: o como una dirección de una celda de memoria, o como un número natural susceptible de ser manipulado como tal. Supóngase que en la posición de memoria 0×00000100 se encuentra almacenado el número entero de 32 bits 0×0153F2AB y que en la posición 0×00000200 se debe almacenar la dirección de dicho número. Para ello se almacena, a partir de la posición 0×00000200 el número 0×00000100 utilizando los cuatro bytes a partir de esa posición y se hace en orden creciente de significación al utilizar el esquema little endian.

En los dispositivos de almacenamiento del computador, se almacenan en forma temporal o permanentemente los programas y datos que son manejados por las aplicaciones que se ejecutan en estos sistemas.

REPORT THIS AD

Debido a la cantidad de información que es manejada actualmente por los usuarios, los dispositivos de almacenamiento se han vuelto casi tan importantes como el computador. Aunque actualmente existen dispositivos para almacenar que superan los 650 MB de memoria; no es suficiente por la falta de capacidad para transportar los documentos y hacer reserva de la información más importante.

Es por tal razón que hoy en día existen diferentes dispositivos de almacenamiento, que tienen su propia tecnología. En la presente investigación se estudiaran todos y cada uno de los dispositivos de almacenamiento de un computador, las distintas marcas, clasificación, entre otros puntos que se irán desarrollando a medida que se avanza en la investigación.

Los sistemas informáticos pueden almacenar los datos tanto interna (en la memoria) como externamente (en los dispositivos de almacenamiento). Internamente, las instrucciones o datos pueden almacenarse por un tiempo en los chips de silicio de la RAM (memoria de acceso aleatorio) montados directamente en la placa de circuitos principal de la computadora, o bien en chips montados en tarjetas periféricas conectadas a la placa de circuitos principal del ordenador. Estos chips de RAM constan de conmutadores sensibles a los cambios de la corriente eléctrica, esto quiere decir que los datos son almacenados por tiempo limitado (hasta que dejamos de suministrar energía eléctrica) por esta razón aparecen los dispositivos de almacenamiento secundarios o auxiliares, los cuales son capaces de conservar la información de manera permanente, mientras su estado físico sea óptimo. Los dispositivos de almacenamiento externo pueden residir dentro del CPU y están fuera de la placa de circuito principal.

3 unidad identificadores

en los lenguajes informáticos, los identificadores son elementos textuales (también llamados símbolos) que nombran entidades del lenguaje. Algunas de las entidades que un identificador puede denotar son las variables, las constantes, los tipos de dato, las etiquetas, las subrutinas (procedimientos y funciones) y los paquetes.

En muchos lenguajes algunas secuencias tienen la forma léxica de un identificador pero son conocidos como palabras clave (o palabras reservadas). Lo habitual es que si un identificador se corresponde con una palabra clave o reservada, éste ya no pueda utilizarse para referirse a otro tipo de entidades como variables o constantes (en unos pocos lenguajes, como PL/1, esta distinción no está del todo clara).

Los lenguajes informáticos normalmente ponen restricciones en qué caracteres pueden aparecer en un identificador. Por ejemplo, en las primeras versiones de C y C++, los identificadores están restringidos para que sean una secuencia de una o más letras ASCII, dígitos numéricos (que en ningún caso deben aparecer como primer carácter) y barras bajas. Las versiones posteriores de estos lenguajes, así como otros muchos más lenguajes modernos soportan casi todos los caracteres Unicode en un identificador. Una restricción común es que no está permitido el uso de espacios en blanco ni operadores del lenguaje.

En lenguajes de programación compilados, los identificadores generalmente son entidades en tiempo de compilación, es decir, en tiempo de ejecución el programa compilado contiene referencias a direcciones de memoria y offsets más que identificadores textuales (estas direcciones de memoria u offsets, han sido asignadas por el compilador a cada identificador).

En lenguajes interpretados los identificadores están frecuentemente en tiempo de ejecución, a veces incluso como objetos de primera clase que pueden ser manipulados y evaluados libremente. En Lisp, éstos se llaman símbolos.

Los compiladores e intérpretes normalmente no asignan ningún significado semántico a un identificador basado en la secuencia de caracteres actual. Sin embargo, hay excepciones. Por ejemplo:

- En Perl una variable se indica utilizando un prefijo llamado sigil, que especifica aspectos de cómo se interpreta la variable en las expresiones.

- En Ruby una variable se considera automáticamente como inmutable si su identificador empieza con una letra mayúscula.

- En Fortran, la primera letra de una variable indica si por defecto es creada como entero o como flotante.

3 unidad tipos de datos

Tipos de Datos

4 respuestas

En programación, un tipo de dato informático o simplemente tipo es un atributo de los datos que indica al ordenador (y/o al programador) sobre la clase de datos que se va a trabajar. Esto incluye imponer restricciones en los datos, como qué valores pueden tomar y qué operaciones se pueden realizar.

Los tipos de datos comunes son: números enteros, números con signo (negativos), números de coma flotante (decimales), cadenas alfanuméricas, estados (booleano)

Un tipo de datos es la propiedad de un valor que determina su dominio (qué valores puede tomar), qué operaciones se le pueden aplicar y cómo es representado internamente por el computador.

Todos los valores que aparecen en un programa tienen un tipo.

A continuación revisaremos los tipos de datos elementales de Python. Además de éstos, existen muchos otros, y más adelante aprenderemos a crear nuestros propios tipos de datos.

Números enteros

El tipo int (del inglés integer, que significa «entero») permite representar números enteros.

Los valores que puede tomar un int son todos los números enteros: ... -3, -2, -1, 0, 1, 2, 3, ...

Los números enteros literales se escriben con un signo opcional seguido por una secuencia de dígitos:

3 unidad Estructura básica de un programa

Estructura

básica de un programa.

|

Como ya se ha visto, cuando se escribe

un programa lo que se trata de hacer es indicarle a la computadora cómo ha de

resolver un problema. Estos programas siguen determinada estructuras, que

dependen del tipo de lenguaje que usemos y del entorno en el cual lo creemos.

Principios generales:

La Mayoría de

programas siguen una de dos estructuras:

Estos se ejecutan típicamente desde una línea de

comando o automáticamente desde otra aplicación y tienden al siguiente patrón

La mayor parte de las interfaces responden a

eventos

Los

programas controlados por eventos son generalmente así:

Estructura Básica de

un programa en C/C++:

La

estructura de un programa es una cuestión que puede ser abordada desde varios

puntos de vista, consideremos para su estudio solo este caso. .

1. Componentes lógicos se refiere a los

diversos elementos que componen una aplicación, desde los más complejos hasta

los más simples. Si comparamos un programa con un edificio, los elementos

irían desde el edificio como un todo, a los ladrillos (sus elementos más

pequeños).

2. Estructura lógica.Desde el punto de

vista lógico, puede considerarse que los programas comprenden dos tipos de

elementos diferentes: estructuras de datos y algoritmos. O dicho en

otras palabras: datos, e instrucciones para su manipulación. Su

representación codificada adopta dos formas: una entendible por la máquina

(ejecutable y ficheros de datos) y otra entendible por el humano (fuente).

Para el conjunto de ambas puede considerarse una escala conceptual que, si

vamos de lo general a lo particular, podemos representarla como sigue:

•Aplicación :•Comprende ejecutables y datos. Puede haber múltiples ficheros de ambos tipos (ficheros de datos y ejecutables) •Programa : •Parte de una aplicación (código) que puede cargarse y ejecutarse independientemente. •Fichero fuente:•Se llaman así (abreviadamente) los ficheros que contienen el código fuente (ficheros .C / .CPP) escrito por el programador •Función: Una parte de un programa (subrutina) con un nombre, que puede ser invocada (llamada a ejecución) desde otras partes tantas veces como se desee. Opcionalmente puede recibir valores (argumentos); se ejecuta y puede devolver un valor •Bloque: •Lista, que puede estar vacía, de sentencias delimitadas •Sentencia: •Las sentencias se componen de una o varias expresiones y tienen sentido computacional completo •Expresión: •Las expresiones son secuencias de tokens (operadores, operandos y elementos de puntuación) que especifican una computación; tienen sentido computacional en sí mismas. Son los bloques de computación más simples con los que se construye un programa [6 §5] aunque no pueden ejecutarse separadamente sino cuando forman una sentencia. Nota: la diferencia entre sentencia y expresión es algo arbitraria. |

3 unidad introducción y estructura del entorno de un lenguaje de programación

introducción y estructura del entorno de un lenguaje de programación

es un lenguaje imperativo orientado a objetos derivado del C. En realidad un superconjunto de C, que nació para añadirle cualidades y características de las que carecía. El resultado es que como su ancestro, sigue muy ligado al hardware subyacente, manteniendo una considerable potencia para programación a bajo nivel, pero se la han añadido elementos que le permiten también un estilo de programación con alto nivel de abstracción. Estrictamente hablando, C no es un subconjunto de C++; de hecho es posible escribir código C que es ilegal en C++. Pero a efectos prácticos, dado el esfuerzo de compatibilidad desplegado en su diseño, puede considerarse que C++ es una extensión del C clásico. La definición "oficial" del lenguaje nos dice que C++ es un lenguaje de propósito general basado en el C, al que se han añadido nuevos tipos de datos, clases, plantillas, mecanismo de excepciones, sistema de espacios de nombres, funciones inline, sobrecarga de operadores, referencias, operadores para manejo de memoria persistente, y algunas utilidades adicionales de librería (en realidad la librería Estándar C es un subconjunto de la librería C++)

3.1 INTRODUCCION A LA PROGRAMACION

A principios de la década de los ochenta llegaban a los hogares de los usuarios los primeros microordenadores. Máquinas casi olvidadas, como los Sinclair ZX-81, o como el mítico Sinclair ZX-Spectrum, el Amstrad CPC-464, etc.

Todos estos equipos tenían un punto en común: el único software con que se entregaban era, por regla general, un sencillo intérprete de lenguaje BASIC. Cuando el usuario conectaba su ordenador, no encontraba un entorno gráfico, en su lugar encontraba una pantalla con una línea de comandos, esperando a recibir órdenes. Cuando se conseguía combinar varias órdenes consecutivas, obteniéndose un resultado satisfactorio, ya se sabía programar. En cierto sentido programar es, por lo tanto, enseñar a una máquina a hacer algo.

3.1.1 DEFINICION DE PROGRAMA

Es un conjunto de instrucciones u ordenes basadas en un lenguaje de programación que una computadora interpreta para resolver un problema o una función Especifica:

Es la relación ordenada de actividades, en informática se le conoce como la serie codificada de instrucciones.

Redacción de un algoritmo en un lenguaje de programación.

Conjunto de instrucciones ordenadas correctamente que permiten realizar una tarea o trabajo específico.

Toda secuencia de instrucciones o indicaciones destinadas a ser utilizadas, directa o indirectamente, en un sistema informático para realizar una función o una tarea o para obtener un resultado determinado, cualquiera que fuere su forma de expresión y fijación.

Conjunto secuenciado de instrucciones que quedan escritas en un lenguaje determinado con unos fines específicos. Aunque en el lenguaje común con frecuencia se denomina programa al sistema operativo, la diferencia estriba, precisamente, en la especificidad de aquél frente al carácter de gestión global de éste. La palabra software engloba ambos.

3.1.2 DEFINICION DE PROGRAMACION

Se conoce como programación de computadores a la implementación de un algoritmo en un determinado lenguaje de programación, conformando un programa. Mientras que un algoritmo se ejecuta en una máquina abstracta que no tiene limitaciones de memoria tiempo, un programa se ejecuta en una máquina real, que sí tiene esas limitaciones. El lenguaje de programación puede ser de alto nivel, medio nivel o bajo nivel, en función del grado de abstracción.

3.1.3 DEFINICION DEL LENGUAJE DE PROGRAMACION

Es aquel elemento dentro de la informática que nos permite crear programas mediante un conjunto de instrucciones, operadores y reglas de sintaxis; que pone a disposición del programador para que este pueda comunicarse con los dispositivos hardware y software existentes.

Suscribirse a:

Comentarios (Atom)